14/02/2024

Descobreix què és la IA generativa, com funciona i les diferències principals de la IA tradicional en aquest blog.

El 2023 ha estat, indubtablement, l’any de la intel·ligència artificial generativa (IAG). S’han produït nombrosos avenços destacables en aquest àmbit i, al llarg de l’any, han anat sortint notícies sobre com la IA generativa ens pot ajudar en el dia a dia i els riscos que comporta.

Però, sabem què és la IA generativa i la diferència que hi ha amb els models d’IA tradicional?

No et perdis l’oportunitat d’endinsar-te en l’emocionant univers de la intel·ligència artificial generativa (IAG)! Si vols descobrir com aquesta innovadora tecnologia transformarà la nostra rutina el 2024, continua llegint!

IA tradicional vs. IA generativa, quines en són les diferències principals?

Explorar les diferències entre la IA tradicional i la IA generativa és essencial per comprendre l’evolució tecnològica. La IA tradicional es basa en algoritmes predefinits i dades històriques per fer tasques especifiques, mentre que la IA generativa va més enllà, crea contingut originals i s’adapta a noves situacions de manera creativa.

Els models d’IA tradicionals es basen en algoritmes que segueixen unes regles predefinides i que estan pensades per resoldre tasques específiques, però no poden generalitzar ni adaptar-se a nous contextos. En canvi, la intel·ligència artificial generativa és una branca de la intel·ligència artificial que se centra en la generació de contingut (nou i original), com ara imatges, text, música, processament de veu, vídeo, etc. La IAG fa servir tècniques d’aprenentatge automàtic i xarxes neuronals per crear models capaços de generar contingut similar a aquell que hi ha en conjunts de dades d’entrenament.

Com funciona la intel·ligència artificial generativa?

El funcionament de la intel·ligència artificial generativa varia segons l’enfocament utilitzat, però, sovint es basa en l’ús de xarxes neuronals amb arquitectura transformer.

Arquitectura transformer: l’arquitectura transformer està pensada perquè els models d’IA vagin aprenent relacions rellevants entre les diferents parts que componen les dades d’entrada (per exemple, entre les paraules que formen el text d’entrada d’un model de generació de text) i les facin servir per produir un resultat a partir d’elles.

Per exemple, un model com el xat GPT “calcula” les relacions entre les paraules que componen les instruccions que se li passen i genera text concatenant les paraules que li semblen més probables a partir d’aquest patró de relacions.

Aquesta arquitectura, juntament amb el mecanisme de Reinforcement Learning from Human Feedback, que expliquem més endavant, conformen els dos pilars fonamentals que han obert el camí cap als Large Language Models (LLM), tal com els coneixem avui, el 2024.

Què són els LLM, per a què serveixen i com funcionen?

Els Large Language Models (LLM) o models de llenguatge de gran escala són sistemes d’intel·ligència artificial dissenyats per comprendre i generar llenguatge simulant el comportament humà. Aquests models s’entrenen fent servir conjunts de tècniques d’aprenentatge automàtic, especialment l’aprenentatge profund, amb gran quantitat de dades.

El funcionament dels LLM es basa en xarxes neuronals i, gairebé en tots els casos, en arquitectura transformer, com el model GPT-3 (Generative Pre-trained Transformer 3), desenvolupat per OpenAI.

Aquests models estan formats per múltiples capes d’unitats de processament que s’interconnecten i aprenen a través de milions o, fins i tot, milers de milions d’exemples de text.

Com s’entrenen els LLM?

Durant l’entrenament, els LLM s’entrenen amb grans quantitats de text, llibres, articles de notícies, pàgines web i altres recursos disponibles al web. Fent servir tècniques de processament del llenguatge natural i aprenentatge supervisat, els models aprenen patrons, relacions i estructures del llenguatge, com també la capacitat de predir la paraula següent en un context donat.

Per fer servir un LLM, se li ha de proporcionar un context o una entrada de text, com més ric sigui el context més precisa serà la resposta del model. D’altra banda, el model, amb les dades d’entrada i el coneixement previ adquirit durant l’entrenament, generarà una resposta.

Els LLM són models estadístics i no tenen una comprensió profunda ni del significat ni del context dels textos, amb què poden generar, en alguns casos, respostes molt encertades, però també cometre errors i generar resultats incorrectes o incoherents. Aquestes respostes són les que anomenem al·lucinacions. A més, els LLM també poden cometre errors a causa de biaixos inherents en les dades d’entrenament, cosa que pot influir en els resultats generats.

Un cop un LLM ha estat entrenat, es pot fer servir per fer una àmplia gamma de tasques relacionades amb el llenguatge. Per exemple, es pot fer servir per completar oracions o textos, respondre preguntes, traduir textos d’un idioma a un altre, generar text coherent i rellevant, resumir documents, entre altres aplicacions.

Però, també, poden donar respostes inapropiades i, per això, es poden (i s’ha de fer) prendre diferents mesures perquè aquests models siguin Helpful-Honest-Harmless, és a dir, que proporcionin ajuda sent honestos i innocus.

RLHF per obtenir respostes més encertades i honestes

Però, com ens podem assegurar que no són perillosos i que es poden alliberar al públic sense perill?

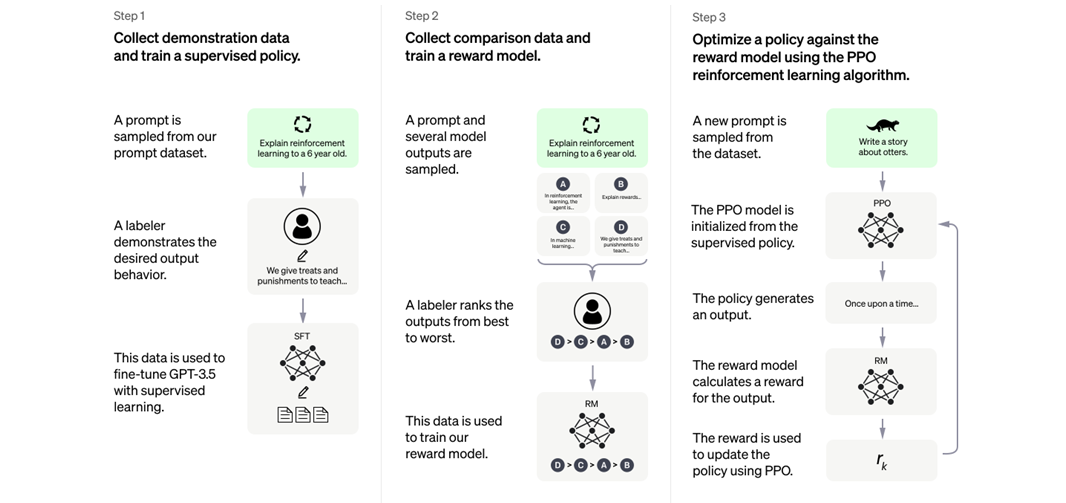

L’altre avenç fonamental en el camp de la IA generativa, que ha permès desenvolupar models com el GPT 3.5, que són molt més fiables que els que hi havia anteriorment, és el mecanisme de reinforcement earning from human feedback (RLHF).

Com funciona el RLHF?

Es passen preguntes i les respostes generades per l’LLM a un grup de persones que avaluen si la resposta és de qualitat o si, en canvi, incompleix les normes. Això retroalimenta el model mitjançant “premis o penalitzacions”, cosa que permet reajustar els paràmetres gràcies a l’aprenentatge per reforç.

Més en detall, per al RLHF se segueixen 3 pautes perquè els resultats tornats pels models d’IA s’alineïn molt més amb el que s’esperaria d’un agent humà:

- El model LLM s’entrena amb parelles de prompts (és a dir, “instruccions” que el model ha de seguir per generar un output) i els outputs respectius esperats.

- Després, per a un conjunt extens de prompts, es fa servir el model LLM per produir diferents outputs per a un mateix prompt i se li assigna una puntuació a cada output

- Finalment, el set de respostes i punts es fa servir per entrenar un model de reinforcement learning que esbiaixa el model LLM cap a respostes que hagin rebut una puntuació més alta al punt 2.

Diagrama que il·lustra els tres passos del RLHF. Font: OpenAI

Taula comparativa sobre els LLM més coneguts

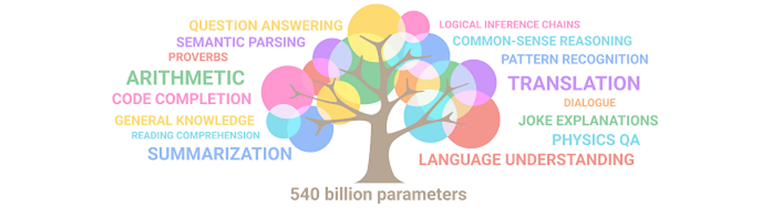

Com podem veure, com més grans són els models més capacitats tenen.

Il·lustració de com emergeixen habilitats en un LLM conforme n’augmenta la mida. Font: Google.

Quines capacitats podem trobar en els models LLM?

Impulsant la intel·ligència artificial generativa a CaixaBank amb GenIAl

A CaixaBank Tech participem activament en el projecte de GenIAl, que té més de 100 professionals dedicats exclusivament a analitzar i desenvolupar aplicacions amb intel·ligència artificial generativa.

Es tracta d’un equip multidisciplinari que treballa i evoluciona en un entorn d’aprenentatge constant. El cert és que l’acord estratègic de col·laboració que CaixaBank manté amb Microsoft ens permet crear i accedir a models i avenços tecnològics que encara no estan disponibles al mercat.

tags:

Comparteix: